Обзор многослойного персептрона (MLP) (обновлено)

Многослойная искусственная нейронная сеть является неотъемлемой частью глубокого обучения. И этот урок поможет вам с обзором многослойной ИНС, а также с переоснащением и недостатком. Мало того, к концу урока вы также узнаете:

- Проанализируйте, как регуляризовать и минимизировать функцию стоимости в нейронной сети.

- Выполните обратное распространение ошибки для корректировки весов в нейронной сети.

- Проверьте сходимость в многослойной ИНС.

- Исследуйте многослойную ИНС

- Реализация прямого распространения в многослойном персептроне (MLP)

- Понять, как на емкость модели влияет недостаточное и переоснащение.

Ваша карьера в области искусственного интеллекта и машинного обучения уже не за горами! Магистерская программа AI EngineerИзучите программу![]()

Понимание однослойной ИНС

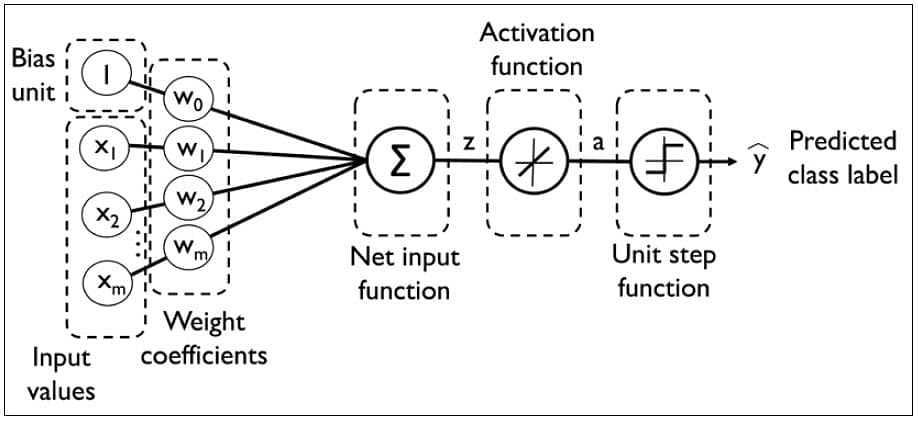

Правило перцептрона и правило Адалины использовались для обучения однослойной нейронной сети.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

Веса обновляются на основе единичной функции в правиле перцептрона или линейной функции в правиле Адалина.

История многослойной ИНС

Глубокое обучение занимается обучением многослойных искусственных нейронных сетей, также называемых глубокими нейронными сетями. После разработки перцептрона Розенблатта в 1950-х годах интерес к нейронным сетям не проявлялся до 1986 года, когда доктор Хинтон и его коллеги разработали алгоритм обратного распространения ошибки для обучения многослойной нейронной сети. Сегодня это горячая тема для многих ведущих компаний, таких как Google, Facebook и Microsoft, которые вкладывают значительные средства в приложения, использующие глубокие нейронные сети.

Многослойная ИНС

Полносвязная многослойная нейронная сеть называется многослойным перцептроном (MLP).

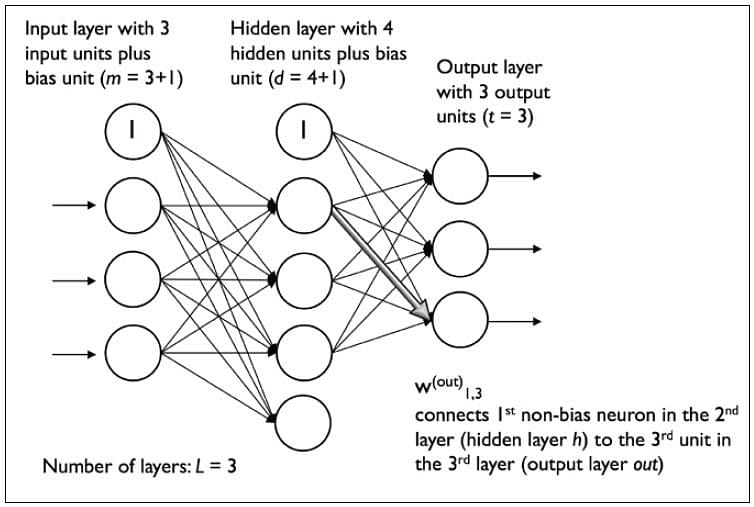

Он имеет 3 слоя, включая один скрытый слой. Если у него более одного скрытого слоя, его называют глубокой ИНС. MLP — типичный пример искусственной нейронной сети прямого распространения. На этом рисунке i-й блок активации в l-м слое обозначен как ai(l).

Количество слоев и количество нейронов называются гиперпараметрами нейронной сети, и они требуют настройки. Чтобы найти для них идеальные значения, необходимо использовать методы перекрестной проверки.

Обучение корректировке веса осуществляется посредством обратного распространения ошибки. Более глубокие нейронные сети лучше обрабатывают данные. Однако более глубокие слои могут привести к исчезновению проблем с градиентом. Для решения этой проблемы необходимы специальные алгоритмы.

Обозначения

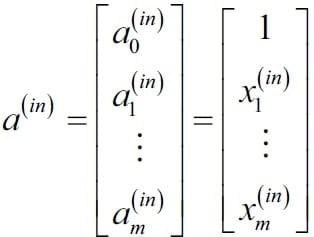

В представлении ниже:

- ai(in) относится к i-му значению во входном слое

- ai(h) относится к i-й единице скрытого слоя.

- ai(out) относится к i-му устройству выходного слоя.

- ao(in) — это просто единица смещения, равная 1; он будет иметь соответствующий вес w0

- Весовой коэффициент от слоя l к слою l+1 представлен wk,j(l)

Упрощенный вид многослоя представлен здесь. На этом изображении показана полностью связанная трехслойная нейронная сеть с 3 входными нейронами и 3 выходными нейронами. Ко входному вектору добавляется фактор смещения.

Ваша карьера в области искусственного интеллекта и машинного обучения уже не за горами! Магистерская программа AI EngineerИзучите программу![]()

Прямое распространение

В следующих темах давайте подробно рассмотрим прямое распространение.

Процедура обучения MLP

Процедура обучения MLP следующая:

- Начиная с входного слоя, передайте данные на выходной слой. Этот шаг является прямым распространением.

- На основе выходных данных вычислите ошибку (разницу между прогнозируемым и известным результатом). Ошибка должна быть минимизирована.

- Обратное распространение ошибки. Найдите его производную по каждому весу в сети и обновите модель.

Повторите три шага, приведенные выше, в течение нескольких эпох, чтобы узнать идеальные веса.

Наконец, выходные данные принимаются через пороговую функцию для получения прогнозируемых меток классов.

Прямое распространение в MLP

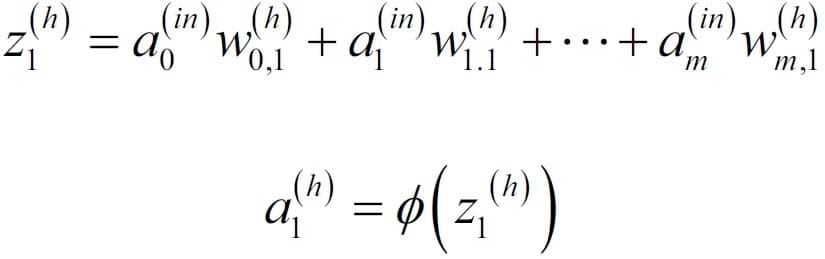

На первом этапе вычислите единицу активации al(h) скрытого слоя.

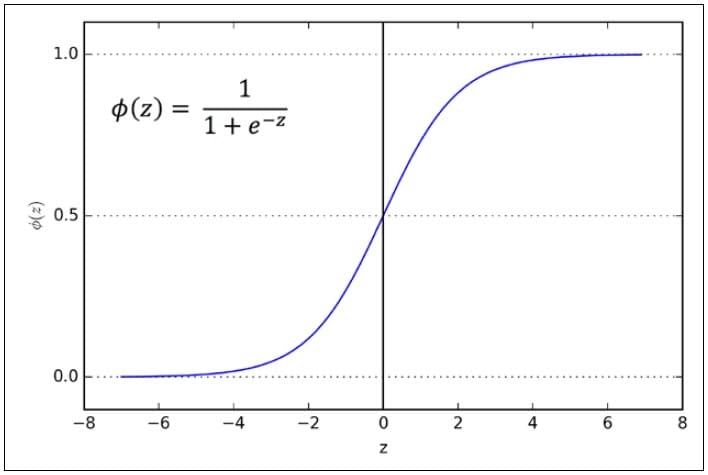

Единица активации — это результат применения функции активации φ к значению z. Он должен быть дифференцируемым, чтобы иметь возможность изучать веса с помощью градиентного спуска. Функция активации φ часто является сигмовидной (логистической) функцией.

Это обеспечивает нелинейность, необходимую для решения сложных задач, таких как обработка изображений.

Сигмовидная кривая

Сигмовидная кривая представляет собой S-образную кривую.

Активация скрытого слоя

Активация скрытого слоя представляется как:

z(h) = a(in) W(h)

а(ч) =

Для выходного слоя:

Z(выход) = A(h) W(выход)

А(выход) =

Выберите правильную программу

Улучшите свою карьеру в области искусственного интеллекта и машинного обучения с помощью комплексных курсов Simplilearn. Получите навыки и знания, которые помогут преобразовать отрасли и раскрыть свой истинный потенциал. Зарегистрируйтесь сейчас и откройте безграничные возможности!

Название программы | Инженер по искусственному интеллекту | Последипломная программа в области искусственного интеллекта | Последипломная программа в области искусственного интеллекта |

| Гео | Все регионы | Все регионы | В/СТРОКА |

| Университет | Простое обучение | Пердью | Калтех |

| Длительность курса | 11 месяцев | 11 месяцев | 11 месяцев |

| Требуется опыт кодирования | Базовый | Базовый | Нет |

| Навыки, которые вы изучите | Более 10 навыков, включая структуру данных, манипулирование данными, NumPy, Scikit-Learn, Tableau и многое другое. | 16+ навыков, включая чат-боты, НЛП, Python, Keras и многое другое. | 8+ навыков, включая Контролируемое и неконтролируемое обучение Глубокое обучение Визуализация данных и многое другое. |

| Дополнительные преимущества | Получите доступ к эксклюзивным хакатонам, мастер-классам и сеансам «Спроси меня о чем-нибудь» от IBM Прикладное обучение посредством 3 основных и 12 отраслевых проектов. | Членство в Ассоциации выпускников Purdue Бесплатное членство в IIMJobs на 6 месяцев Помощь в составлении резюме | До 14 кредитов CEU Членство в кружке Caltech CTME |

| Расходы | $$ | $$$$ | $$$$ |

| Изучите программу | Изучите программу | Изучите программу |

Заключение

Технологии нового века, такие как искусственный интеллект, машинное обучение и глубокое обучение, распространяются быстрыми темпами. И если вы хотите сохранить свою работу, овладение этими новыми технологиями будет обязательным.

В этом уроке рассмотрено все, что касается многослойных искусственных нейронных сетей. Однако, если вы хотите овладеть искусственным интеллектом и машинным обучением, вашей следующей остановкой должна стать программа последипломного образования в области искусственного интеллекта, проводимая в партнерстве с IBM. Благодаря мастер-классам лучших преподавателей Калифорнийского технологического института и онлайн-лагерю Simplilearn станьте профессионалом в области искусственного интеллекта и машинного обучения, как никогда раньше!

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)