Кривая ROC и AUC в машинном обучении: полное руководство!

Модели машинного обучения — это математические движки, которые управляют искусственным интеллектом, и поэтому они крайне важны для успешного внедрения ИИ. Фактически, можно сказать, что ваш ИИ настолько хорош, насколько хороши машинные модели, которые им управляют.

Итак, убедившись в важности хорошей модели машинного обучения, вы беретесь за дело и после упорной работы наконец создаете то, что считаете отличной моделью машинного обучения. Поздравляем!

Но ждать. Как определить, насколько хороша ваша модель машинного обучения? Очевидно, что вам нужны объективные средства измерения производительности вашей модели машинного обучения и определения того, достаточно ли она хороша для реализации. Было бы полезно, если бы у вас была кривая ROC.

В этой статье есть все, что вам нужно знать о кривых ROC. Мы определим кривые ROC и термин «площадь под кривой ROC», узнаем, как использовать кривые ROC в моделировании производительности, а также получим множество другой ценной информации. Начнем с некоторых определений.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

Что такое ROC-кривая?

Кривая ROC (что означает «рабочая характеристика приемника») — это график, который показывает производительность модели классификации при всех пороговых значениях классификации. Это кривая вероятности, которая отображает два параметра: истинно положительный уровень (TPR) и ложный положительный уровень (FPR) при различных пороговых значениях и отделяет так называемый «сигнал» от «шума».

Кривая ROC отображает уровень истинного положительного результата в сравнении с уровнем ложноположительного результата при различных пороговых значениях классификации. Если пользователь снижает порог классификации, больше элементов классифицируются как положительные, что увеличивает как ложные, так и истинные положительные результаты. Вы можете увидеть некоторые изображения по этому поводу здесь.

Кривая ROC

Кривая ROC (Receiver Operating Characteristic) — это графическое представление, используемое для оценки производительности бинарного классификатора. Она отображает две ключевые метрики:

- Доля истинных положительных результатов (TPR): также известный как чувствительность или отзыв, он измеряет долю фактических положительных результатов, правильно определенных моделью. Он рассчитывается как:

TPR=Истинно положительные результаты/(TP)Истинно положительные результаты (TP)+Ложно отрицательные результаты - Доля ложноположительных результатов (FPR): измеряет долю фактических негативов, ошибочно идентифицированных моделью как позитивы. Он рассчитывается как:

FPR = ложноположительные результаты (FP)/ложноположительные результаты (FP)+истинно отрицательные результаты (TN)

Кривая ROC отображает TPR (ось Y) против FPR (ось X) при различных пороговых значениях. Вот более подробное объяснение этих показателей:

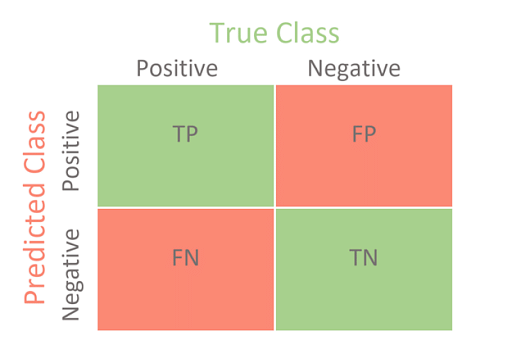

- Истинно положительный (TP): экземпляр положительный, и модель правильно классифицирует его как положительный.

- Ложный положительный результат (FP): экземпляр отрицательный, но модель неверно классифицирует его как положительный.

- Истинно отрицательный (TN): экземпляр отрицательный, и модель правильно классифицирует его как отрицательный.

- Ложноотрицательный результат (FN): экземпляр положительный, но модель неправильно классифицирует его как отрицательный.

Интерпретация ROC-кривой

- Кривая, расположенная ближе к верхнему левому углу, указывает на более эффективную модель.

- Диагональная линия (от (0,0) до (1,1)) представляет собой случайный классификатор.

- Площадь под кривой ROC (AUC) — это одно скалярное значение, которое измеряет общую производительность модели. Он варьируется от 0 до 1, а более высокий показатель AUC указывает на более эффективную модель.

Площадь под кривой ROC (AUC)

Площадь под кривой ROC (AUC) — это единичное скалярное значение, которое суммирует общую производительность модели бинарной классификации. Оно измеряет способность модели различать положительные и отрицательные классы. Вот что вам нужно знать о AUC:

Ключевые моменты об AUC

Диапазон AUC:

- Значение AUC варьируется от 0 до 1.

- AUC 0,5 указывает на то, что модель работает не лучше, чем случайная случайность.

- AUC ближе к 1 указывает на модель с отличными характеристиками.

Интерпретация значений AUC:

- 0,9 – 1,0: Отлично

- 0,8 – 0,9: Хорошо

- 0,7 – 0,8: Удовлетворительно

- 0,6–0,7: Плохо

- 0,5–0,6: Не удалось

Преимущества использования AUC:

- Независимый от порога: AUC оценивает производительность модели по всем возможным порогам классификации.

- Масштабный инвариант: AUC измеряет степень ранжирования прогнозов, а не их абсолютные значения.

Расчет AUC:

- AUC обычно рассчитывается с использованием методов численного интегрирования, таких как правило трапеций, применяемое к кривой ROC.

- На практике библиотеки, такие как Scikit-learn в Python, предоставляют функции для вычисления AUC непосредственно из прогнозов модели и истинных меток.

Ключевые термины, используемые в кривых AUC и ROC

1. Истинно позитивный (TP)

- Определение: количество положительных случаев, правильно идентифицированных моделью.

- Пример: В медицинском тесте TP имеет место, когда тест правильно определяет наличие заболевания у человека.

2. Истинно отрицательный результат (TN)

- Определение: количество отрицательных случаев, правильно идентифицированных моделью.

- Пример: В спам-фильтре TN появляется, когда легитимное электронное письмо правильно идентифицируется как не спам.

3. Ложное срабатывание (FP)

- Определение: количество отрицательных случаев, ошибочно определенных моделью как положительные.

- Пример: в системе обнаружения мошенничества FP возникает, когда законная транзакция ошибочно помечается как мошенническая.

4. Ложноотрицательный результат (ЛОР)

- Определение: количество положительных случаев, ошибочно определенных моделью как отрицательные.

- Пример: В скрининговом тесте на рак ФН – это когда у человека, больного раком, ошибочно определяется отсутствие рака.

5. Истинно положительный показатель (TPR)

- Определение: Также известный как чувствительность или полнота, он измеряет долю фактических положительных результатов, которые правильно идентифицированы моделью.

- Формула: TPR=TP/TP+FN

- Пример: TPR, равный 0,8, означает, что 80% реальных положительных случаев идентифицированы правильно.

6. Коэффициент ложноположительных результатов (FPR)

- Определение: он измеряет долю фактических негативов, которые модель ошибочно идентифицирует как позитивные.

- Формула: FPR=FP/FP+TN

- Пример: FPR, равный 0,1, означает, что 10% реальных отрицательных случаев идентифицированы неправильно.

7. Порог

- Определение: Значение, при котором прогноз модели преобразуется в бинарную классификацию. Регулируя порог, можно получить различные значения TPR и FPR.

- Пример: в задаче бинарной классификации пороговое значение 0,5 может означать, что прогнозируемые вероятности выше 0,5 классифицируются как положительные.

8. Кривая ROC

- Определение: графический график, иллюстрирующий диагностические возможности бинарного классификатора, поскольку его порог дискриминации варьируется. Он отображает зависимость TPR от FPR при различных пороговых значениях.

- Пример: кривая ROC, расположенная рядом с верхним левым углом, указывает на более эффективную модель.

9. Площадь под кривой (AUC)

- Определение: Единичное скалярное значение, суммирующее общую производительность бинарного классификатора по всем возможным пороговым значениям. Это площадь под кривой ROC.

- Диапазон: от 0 до 1, где 1 означает идеальную производительность, а 0,5 — не лучше, чем случайное угадывание.

- Пример: AUC 0,9 указывает на отличную производительность.

10. Точность

- Определение: доля положительных идентификаций, которые на самом деле верны.

- Формула: Точность=TP/TP+FP

- Пример. Точность 0,75 означает, что 75% случаев, классифицированных как положительные, на самом деле являются положительными.

11. Память (Чувствительность)

- Определение: Другой термин для показателя истинно положительных результатов (TPR), измеряющий долю фактических правильно идентифицированных положительных результатов.

- Пример: Коэффициент полноты 0,8 означает, что 80% фактических положительных случаев идентифицированы правильно.

12. Специфика

- Определение: доля фактических негативов, правильно определенных моделью.

- Формула: Специфичность=TN/TN+FP

- Пример: Специфичность 0,9 означает, что 90% фактических отрицательных случаев идентифицированы правильно.

Что такое ROC-кривая: как оценить эффективность модели?

AUC — ценный инструмент для спекулятивной оценки производительности модели. У превосходной модели AUC близка к 1, что указывает на хорошую меру разделимости. Следовательно, AUC плохой модели склоняется ближе к 0, показывая наихудшую меру разделимости. Фактически, близость к 0 означает, что она меняет результат, предсказывая отрицательный класс как положительный и наоборот, показывая 0 как 1, а 1 как 0. Наконец, если AUC равна 0,5, это показывает, что у модели вообще нет возможности разделения классов.

Итак, когда мы имеем результат 0,5 Прежде чем мы рассмотрим связь между Specificity, FPR, Sensitivity и Threshold, мы должны сначала рассмотреть их определения в контексте моделей машинного обучения. Для этого нам понадобится матрица путаницы, которая поможет нам лучше понять термины. Вот пример матрица путаницы: TP означает True Positive, а TN означает True Negative. FP означает ложноположительный результат, а FN означает ложноотрицательный результат. Вот как математически рассчитать чувствительность: Чувствительность = (истинно положительный результат)/(истинно положительный + ложноотрицательный результат) Вот как рассчитать специфичность: Специфичность = (Истинно отрицательный)/(Истинно отрицательный + Ложно положительный) FPR= 1 – Специфичность Чувствительность и специфичность обратно пропорциональны, поэтому если мы повышаем чувствительность, специфичность падает, и наоборот. Более того, мы получаем больше положительных значений, когда уменьшаем порог, тем самым повышая чувствительность и снижая специфичность. С другой стороны, если мы повысим порог, мы получим больше отрицательных значений, что приведет к более высокой специфичности и более низкой чувствительности. А поскольку FPR равен 1 – специфичность, то когда мы увеличиваем TPR, FPR тоже увеличивается и наоборот. AUC-ROC (площадь под кривой — рабочая характеристика приемника) — это измерение производительности для задач классификации при различных пороговых значениях. Вот как это работает: Метрика AUC-ROC особенно полезна в следующих сценариях: Мы можем использовать методологию «Один против ВСЕХ» для построения N количества кривых AUC ROC для N числовых классов при использовании многоклассовой модели. Один против ВСЕХ дает нам возможность использовать бинарную классификацию. Если у вас есть проблема классификации с N возможными решениями, One vs. ALL предоставляет нам один двоичный классификатор для каждого возможного результата. Например, у вас есть три класса с именами 0, 1 и 2. У вас будет один ROC для 0, классифицированный по 1 и 2, другой ROC для 1, который классифицируется по 0 и 2, и, наконец, третий. из 2 классифицировано против 0 и 1. Нам следует воспользоваться моментом и объяснить методологию «Один против ВСЕХ», чтобы лучше ответить на вопрос «что такое кривая ROC?». Эта методология состоит из N отдельных двоичных классификаторов. Во время обучения модель проходит через последовательность двоичных классификаторов, обучая каждого отвечать на классификационный вопрос. Например, если у вас есть изображение кошки, вы можете обучить четыре разных распознавателя: один воспринимает изображение как положительный пример (кошка), а три других видят отрицательный пример (не кошка). Это будет выглядеть так: Эта методология хорошо работает с небольшим количеством классов. Однако по мере увеличения количества классов модель становится все более неэффективной. Ускорьте свою карьеру в области искусственного интеллекта и машинного обучения с помощью курсов по искусственному интеллекту и машинному обучению Университета Пердью, организованных совместно с IBM. О машинном обучении можно многому научиться, как вы можете понять из этой статьи «что такое ROC-кривая»! Однако и машинное обучение, и искусственный интеллект — это волны будущего, поэтому стоит приобретать навыки и знания в этих областях. Кто знает? Вы можете найти себя в захватывающей карьере в области машинного обучения! Если вы хотите построить карьеру в области машинного обучения, Simplilearn может помочь вам на этом пути. Сертификация AI and ML предлагает студентам углубленный обзор тем машинного обучения. Вы научитесь разрабатывать алгоритмы с использованием контролируемого и неконтролируемого обучения, работать с данными в реальном времени и узнаете о таких концепциях, как регрессия, классификация и моделирование временных рядов. Вы также узнаете, как можно использовать Python для построения прогнозов на основе данных. Кроме того, программа включает 58 часов прикладного обучения, интерактивные лабораторные работы, четыре практических проекта и наставничество. А поскольку машинное обучение и искусственный интеллект так часто работают вместе, ознакомьтесь с магистерской программой Simplilearn «Инженер по искусственному интеллекту» и охватите все аспекты. В соответствии с Стеклянная дверьИнженеры по машинному обучению в Соединенных Штатах получают среднюю годовую базовую заработную плату в размере 133 001 долл. США. По данным Payscale.com, инженеры по машинному обучению в Индии могут потенциально зарабатывать в среднем 732 566 рупий в год. Посетите Simplilearn сегодня и откройте для себя богатые возможности увлекательной профессии в области машинного обучения! Идеальная кривая AUC-ROC достигает верхнего левого угла графика, указывая на True Positive Rate (TPR) 1 и False Positive Rate (FPR) 0 для некоторого порога. Это означает, что модель идеально различает положительные и отрицательные классы, что приводит к значению AUC 1,0. Значение AUC 0,5 означает, что производительность модели не лучше случайного угадывания. Это означает, что модель не может различать положительные и отрицательные классы, поскольку True Positive Rate (TPR) и False Positive Rate (FPR) одинаковы для всех порогов. Чтобы сравнить кривые ROC разных моделей, нанесите кривую ROC каждой модели на один и тот же график и изучите их формы и положения. Модель с кривой ROC, наиболее близкой к верхнему левому углу, и с самым высоким значением площади под кривой (AUC) обычно работает лучше. Некоторые ограничения ROC-кривой включают в себя: К распространенным показателям, полученным из кривых ROC, относятся: Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)Связь между чувствительностью, специфичностью, FPR и порогом

Как работает AUC-ROC

Изменение порога:

Построение ROC-кривой:

Расчет AUC:

Когда использовать метрику оценки AUC-ROC?

Понимание кривой AUC-ROC

1. Интерпретация ROC-кривой

2. Интерпретация значения AUC

Как использовать кривую AUC-ROC для многоклассовой модели

Вы заинтересованы в карьере в области машинного обучения?

Часто задаваемые вопросы

1. Как выглядит идеальная кривая AUC-ROC?

2. Что означает значение AUC 0,5?

3. Как сравнивать ROC-кривые разных моделей?

4. Каковы некоторые ограничения кривой ROC?

5. Какие общие показатели получаются на основе ROC-кривых?