Что такое Персептрон? Руководство для начинающих на 2024 год

Нейросетевая связь, которая содержит вычисления для отслеживания признаков и использует искусственный интеллект во входных данных, известна как персептрон. Эта нейронная связь с искусственными нейронами использует простые логические вентили с бинарными выходами. Искусственный нейрон вызывает математическую функцию и имеет узел, вход, вес и выход, эквивалентные ядру клетки, дендритам, синапсу и аксону соответственно, по сравнению с биологическим нейроном.

Что такое двоичный классификатор в машинном обучении?

Двоичный классификатор в машинном обучении — это тип модели, которая обучена классифицировать данные в одну из двух возможных категорий, обычно представленных в виде двоичных меток, таких как 0 или 1, истина или ложь, положительное или отрицательное. Например, бинарный классификатор может быть обучен различать спам и не спам-письма или предсказывать, является ли транзакция по кредитной карте мошеннической или законной.

Двоичные классификаторы являются фундаментальным строительным блоком многих приложений машинного обучения, и существует множество алгоритмов, которые можно использовать для их построения, включая логистическую регрессию, опорные векторные машины (SVM), деревья решений, случайные леса и нейронные сети. Эти модели обычно обучаются с использованием маркированных данных, где известна правильная метка или категория для каждого примера в обучающем наборе, а затем используются для прогнозирования категории новых, невиданных примеров.

Производительность бинарного классификатора обычно оценивается с использованием таких метрик, как точность, достоверность, отзыв и оценка F1, которые измеряют, насколько хорошо модель способна правильно идентифицировать положительные и отрицательные примеры в данных. Высококачественные бинарные классификаторы необходимы для широкого спектра приложений, включая обработку естественного языка, компьютерное зрение, обнаружение мошенничества и медицинскую диагностику, среди многих других.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

Ваша карьера в области искусственного интеллекта/машинного обучения уже не за горами!Магистерская программа «Инженер искусственного интеллекта»Изучить программу![]()

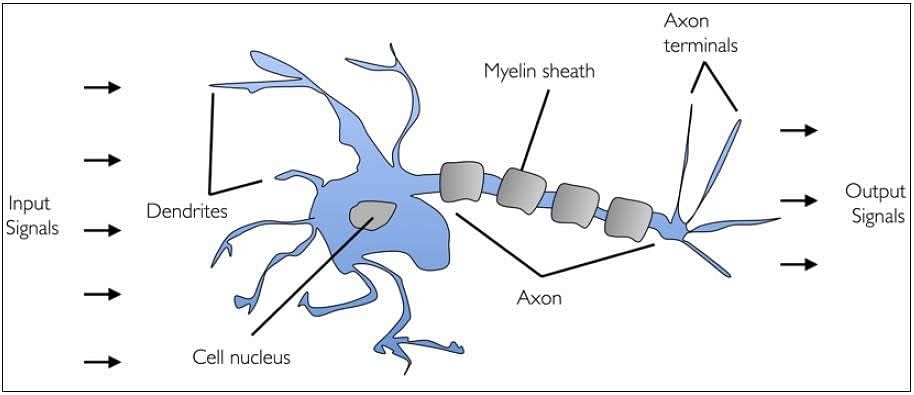

Биологический нейрон

Человеческий мозг состоит из миллиардов нейронов. Нейроны — это взаимосвязанные нервные клетки человеческого мозга, которые участвуют в обработке и передаче химических и электрических сигналов. Дендриты — это ветви, которые получают информацию от других нейронов.

Ядро клетки или сома обрабатывает информацию, полученную от дендритов. Аксон — это кабель, который нейроны используют для передачи информации. Синапс — это соединение между аксоном и дендритами других нейронов.

Давайте обсудим развитие искусственных нейронов в следующем разделе.

Развитие искусственных нейронов (на основе биологических нейронов)

Исследователи Уоррен МакКаллок и Уолтер Питтс опубликовали свою первую концепцию упрощенной мозговой клетки в 1943 году. Она была названа нейроном МакКаллока-Питтса (MCP). Они описали такую нервную клетку как простой логический вентиль с бинарными выходами.

Множественные сигналы поступают на дендриты и затем интегрируются в тело клетки, и, если накопленный сигнал превышает определенный порог, генерируется выходной сигнал, который будет передан аксоном. В следующем разделе поговорим об искусственном нейроне.

Что такое искусственный нейрон

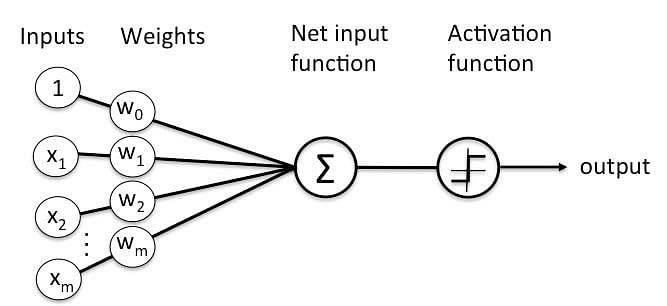

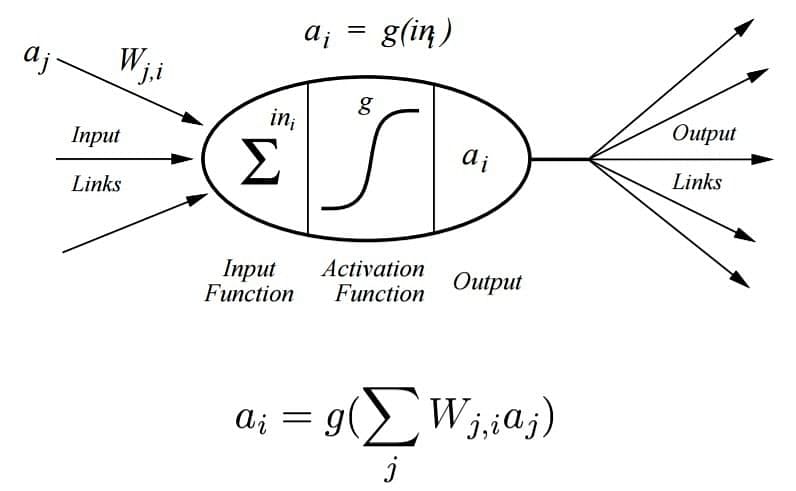

Искусственный нейрон — это математическая функция, основанная на модели биологических нейронов, где каждый нейрон принимает входные данные, взвешивает их по отдельности, суммирует их и пропускает эту сумму через нелинейную функцию для получения выходных данных.

В следующем разделе сравним биологический нейрон с искусственным нейроном.

Освойте стратегии Gen AI для бизнеса с программой Generation AI for Business Transformation ProgramИзучите программу![]()

Биологический нейрон против искусственного нейрона

Биологический нейрон аналогичен искусственным нейронам в следующих отношениях:

Биологический нейрон | Искусственный нейрон |

Ядро клетки (сома) | Узел |

Дендриты | Вход |

Синапс | Веса или взаимосвязи |

Аксон | Выход |

Краткий обзор искусственного нейрона

Искусственный нейрон имеет следующие характеристики:

- Нейрон — это математическая функция, смоделированная на основе работы биологических нейронов.

- Это элементарная единица в искусственной нейронной сети.

- Один или несколько входов взвешиваются отдельно

- Входные данные суммируются и пропускаются через нелинейную функцию для получения выходных данных.

- Каждый нейрон имеет внутреннее состояние, называемое сигналом активации.

- Каждое звено связи несет информацию о входном сигнале.

- Каждый нейрон соединен с другим нейроном посредством соединительной линии.

В следующем разделе поговорим о персептронах.

Персептрон

Персептрон был представлен Фрэнком Розенблаттом в 1957 году. Он предложил правило обучения персептрона на основе оригинального нейрона MCP. Персептрон — это алгоритм контролируемого обучения бинарных классификаторов. Этот алгоритм позволяет нейронам обучаться и обрабатывать элементы в обучающем наборе по одному за раз.

Ваша карьера в области искусственного интеллекта/машинного обучения уже не за горами!Магистерская программа «Инженер искусственного интеллекта»Изучить программу![]()

Основные компоненты персептрона

Персептрон — это тип искусственной нейронной сети, которая является фундаментальной концепцией в машинном обучении. Основные компоненты персептрона:

- Входной слой: Входной слой состоит из одного или нескольких входных нейронов, которые получают входные сигналы из внешнего мира или из других слоев нейронной сети.

- Веса: Каждый входной нейрон связан с весом, который отражает силу связи между входным нейроном и выходным нейроном.

- Смещение: к входному слою добавляется смещение, чтобы обеспечить персептрону дополнительную гибкость при моделировании сложных закономерностей во входных данных.

- Функция активации: Функция активации определяет выход персептрона на основе взвешенной суммы входов и смещенного члена. Обычные функции активации, используемые в персептронах, включают ступенчатую функцию, сигмоидальную функцию и функцию ReLU.

- Выходные данные: Выходные данные персептрона представляют собой одно двоичное значение, 0 или 1, которое указывает класс или категорию, к которой относятся входные данные.

- Алгоритм обучения: Персептрон обычно обучается с использованием контролируемого алгоритма обучения, такого как алгоритм обучения персептрона или обратное распространение. Во время обучения веса и смещения персептрона корректируются для минимизации ошибки между прогнозируемым выходом и истинным выходом для заданного набора обучающих примеров.

- В целом персептрон — это простой, но мощный алгоритм, который можно использовать для выполнения задач двоичной классификации. Он проложил путь для более сложных нейронных сетей, используемых сегодня в глубоком обучении.

Типы персептрона:

- Один слой: Однослойный персептрон может изучать только линейно разделимые шаблоны.

- Многослойность: многослойные персептроны могут обучаться на двух или более слоях, имея большую вычислительную мощность.

Алгоритм Perceptron изучает веса входных сигналов, чтобы построить линейную границу принятия решений.

Примечание: Контролируемое обучение — это тип машинного обучения, используемый для обучения моделей на основе маркированных обучающих данных. Он позволяет прогнозировать выходные данные для будущих или невидимых данных. Давайте сосредоточимся на правиле обучения персептрона в следующем разделе.

Персептрон в машинном обучении

Наиболее часто используемый термин в области искусственного интеллекта и машинного обучения (AIML) — перцептрон. Это начальный этап обучения кодированию и технологиям глубокого обучения, который состоит из входных значений, оценок, пороговых значений и весов, реализующих логические вентили. Перцептрон — это этап развития искусственной нейронной связи. В 19 веке г-н Фрэнк Розенблатт изобрел перцептрон для выполнения определенных высокоуровневых вычислений с целью обнаружения возможностей входных данных или бизнес-аналитики. Однако сейчас он используется для различных других целей.

История персептрона

Персептрон был представлен Фрэнком Розенблаттом в 1958 году как тип искусственной нейронной сети, способной обучаться и выполнять задачи бинарной классификации. Розенблатт был психологом и ученым-компьютерщиком, который интересовался разработкой машины, способной обучаться и распознавать закономерности в данных, вдохновленный работой человеческого мозга.

Персептрон был основан на концепции простого вычислительного блока, который принимает один или несколько входов и производит один выход, смоделированный по структуре и функции нейрона в мозге. Персептрон был разработан, чтобы иметь возможность обучаться на примерах и корректировать свои параметры для повышения точности классификации новых примеров.

Алгоритм персептрона изначально использовался для решения простых задач, таких как распознавание рукописных символов, но вскоре он подвергся критике из-за своей ограниченной способности изучать сложные шаблоны и неспособности обрабатывать нелинейно разделимые данные. Эти ограничения привели к упадку исследований персептронов в 1960-х и 1970-х годах.

Однако в 1980-х годах развитие обратного распространения, мощного алгоритма для обучения многослойных нейронных сетей, возобновило интерес к искусственным нейронным сетям и вызвало новую эру исследований и инноваций в машинном обучении. Сегодня персептроны считаются простейшей формой искусственных нейронных сетей и по-прежнему широко используются в таких приложениях, как распознавание изображений, обработка естественного языка и распознавание речи.

Что такое модель персептрона в машинном обучении?

Машинный алгоритм, используемый для контролируемого обучения различных задач двоичной сортировки, называется персептроном. Кроме того, персептрон также играет важную роль в качестве искусственного нейрона или нейронной связи при обнаружении определенных вычислений входных данных в бизнес-аналитике. Модель персептрона также классифицируется как один из лучших и наиболее специфичных типов искусственных нейронных сетей. Будучи контролируемым алгоритмом обучения двоичных классификаторов, мы также можем считать его однослойной нейронной сетью с четырьмя основными параметрами: входные значения, веса и смещение, чистая сумма и функция активации.

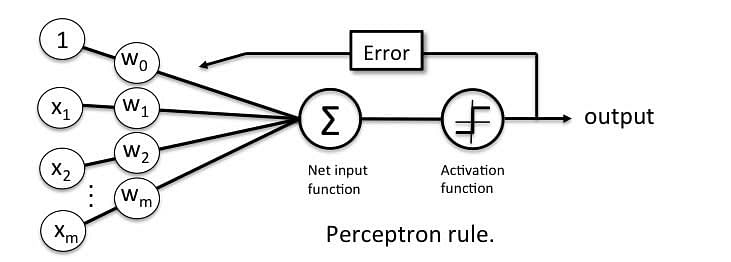

Как работает персептрон?

Как обсуждалось ранее, персептрон считается однослойной нейронной связью с четырьмя основными параметрами. Модель персептрона начинается с умножения всех входных значений и их весов, затем эти значения складываются для создания взвешенной суммы. Далее эта взвешенная сумма применяется к функции активации 'f' для получения желаемого выхода. Эта функция активации также известна как ступенчатая функция и представлена как 'f.'

ИЗОБРАЖЕНИЕ ПРЕДОСТАВЛЕНО: javapoint

Эта ступенчатая функция или функция активации жизненно важна для обеспечения отображения выходных данных между (0,1) или (-1,1). Обратите внимание, что вес входных данных указывает на силу узла. Аналогично, входное значение дает возможность смещать кривую функции активации вверх или вниз.

Шаг 1: Умножьте все входные значения на соответствующие значения веса, а затем сложите, чтобы вычислить взвешенную сумму. Ниже приведено ее математическое выражение:

∑wi*xi = x1*w1 + x2*w2 + x3*w3+……..x4*w4

Добавьте к этой взвешенной сумме член, называемый смещением «b», чтобы улучшить эффективность модели.

Шаг 2: Функция активации применяется с вышеупомянутой взвешенной суммой, давая нам выход либо в двоичной форме, либо в виде непрерывного значения следующим образом:

Y=f(∑wi*xi + b)

Станьте специалистом по обработке данных с помощью практического обучения!Программа магистратуры для специалистов по обработке данныхИзучить программу![]()

Типы моделей персептрона

Мы уже обсуждали типы моделей персептрона во Введении. Здесь мы рассмотрим это более подробно:

- Модель однослойного персептрона: Один из самых простых типов ИНС (искусственных нейронных сетей) состоит из сети прямой связи и включает пороговую передачу внутри модели. Основная цель модели однослойного персептрона — анализ линейно разделимых объектов с бинарными результатами. Однослойный персептрон может изучать только линейно разделимые шаблоны.

- Модель многослойного персептрона: в основном похожа на модель однослойного персептрона, но имеет больше скрытых слоев.

Прямой этап: от входного слоя на этапе включения функции активации начинаются и заканчиваются на выходном слое.

Backward Stage: На backstage значения веса и смещения изменяются в соответствии с требованиями модели. Backstage устраняет ошибку между фактическим выходом и требованиями, возникающими в обратном направлении на выходном слое. Многослойная модель персептрона имеет большую вычислительную мощность и может обрабатывать линейные и нелинейные шаблоны. Кроме того, она также реализует логические вентили, такие как AND, OR, XOR, XNOR и NOR.

Преимущества:

- Многослойная модель персептрона может решать сложные нелинейные задачи.

- Он хорошо работает как с небольшими, так и с большими объемами входных данных.

- Помогает нам получать быстрые прогнозы после обучения.

- Помогает нам добиться одинаковой точности при работе с большими и малыми данными.

Недостатки:

- В многослойной модели персептрона вычисления являются трудоемкими и сложными.

- Трудно предсказать, насколько зависимая переменная влияет на каждую независимую переменную.

- Функционирование модели зависит от качества обучения.

Характеристики модели персептрона

Ниже приведены характеристики модели персептрона:

- Это алгоритм машинного обучения, использующий контролируемое обучение бинарных классификаторов.

- В Perceptron весовой коэффициент изучается автоматически.

- Сначала веса умножаются на входные признаки, а затем принимается решение, активируется нейрон или нет.

- Функция активации применяет правило шага для проверки того, является ли функция более значимой, чем ноль.

- Проводится линейная граница принятия решений, позволяющая различать два линейно разделимых класса +1 и -1.

- Если сумма всех входных значений больше порогового значения, то должен быть выходной сигнал; в противном случае выходной сигнал отображаться не будет.

Ограничение модели персептрона

Ниже приведены ограничения модели персептрона:

- Выход персептрона может быть только двоичным числом (0 или 1) из-за жесткой передаточной функции.

- Его можно использовать только для классификации линейно разделимых множеств входных векторов. Если входные векторы нелинейны, их нелегко правильно классифицировать.

Ваша карьера в области искусственного интеллекта/машинного обучения уже не за горами!Магистерская программа «Инженер искусственного интеллекта»Изучить программу![]()

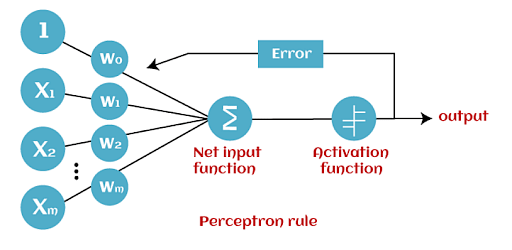

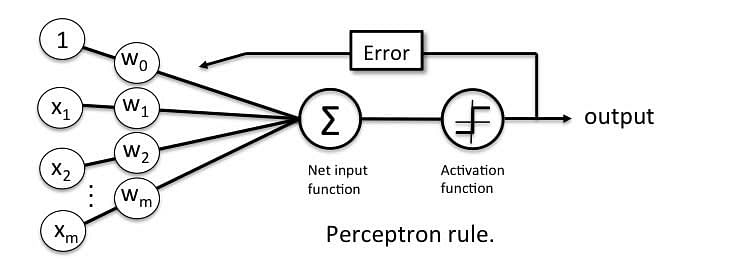

Правило обучения персептрона

Правило обучения персептрона гласит, что алгоритм автоматически выучит оптимальные весовые коэффициенты. Затем входные признаки умножаются на эти веса, чтобы определить, срабатывает нейрон или нет.

Персептрон получает несколько входных сигналов, и если сумма входных сигналов превышает определенный порог, он либо выдает сигнал, либо не возвращает выходной сигнал. В контексте контролируемого обучения и классификации это может затем использоваться для прогнозирования класса образца.

Далее давайте сосредоточимся на функции персептрона.

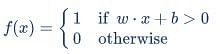

Функция персептрона

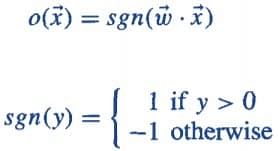

Персептрон — это функция, которая отображает свой вход «x», который умножается на изученный весовой коэффициент; генерируется выходное значение «f(x)».

В приведенном выше уравнении:

- «w» = вектор действительных весов

- «b» = смещение (элемент, который смещает границу от начала координат независимо от входного значения)

- «x» = вектор входных значений x

- «m» = количество входов в персептрон

Выход может быть представлен как «1» или «0». Он также может быть представлен как «1» или «-1» в зависимости от того, какая функция активации используется.

Давайте изучим входные данные персептрона в следующем разделе.

Входы персептрона

Персептрон принимает входные данные, модерирует их с определенными весовыми значениями, затем применяет функцию преобразования для вывода конечного результата. На изображении ниже показан персептрон с булевым выходом.

Булев вывод основан на входных данных, таких как зарплата, женат, возраст, прошлый кредитный профиль и т. д. Он имеет только два значения: Да и Нет или Истина и Ложь. Функция суммирования «∑» умножает все входные данные «x» на веса «w», а затем складывает их следующим образом:

![]()

В следующем разделе рассмотрим функции активации персептронов.

Ваша карьера в области искусственного интеллекта/машинного обучения уже не за горами!Магистерская программа «Инженер искусственного интеллекта»Изучить программу![]()

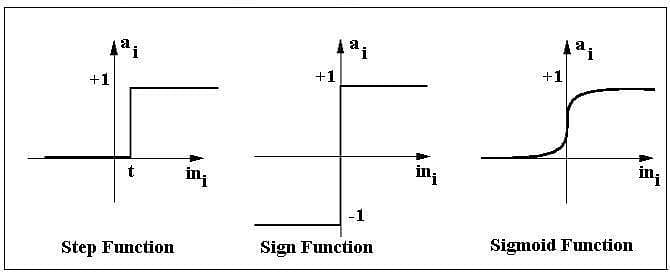

Активационные функции персептрона

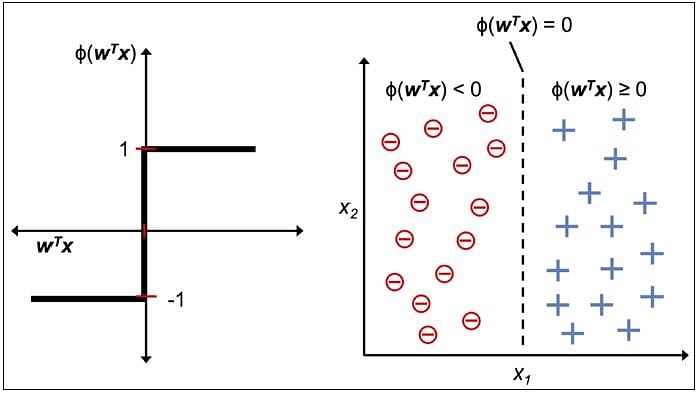

Функция активации применяет правило шага (преобразует числовой выход в +1 или -1), чтобы проверить, больше ли нуля выход весовой функции или нет.

Например:

Если ∑ wixi> 0 => то конечный результат «o» = 1 (выдать банковский кредит)

В противном случае, конечный результат «o» = -1 (отказать в выдаче банковского кредита)

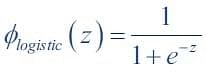

Функция Step срабатывает выше определенного значения выхода нейрона; в противном случае она выводит ноль. Функция Sign выводит +1 или -1 в зависимости от того, больше ли выход нейрона нуля или нет. Сигмоид — это S-образная кривая, которая выводит значение от 0 до 1.

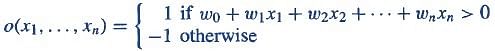

Выход персептрона

Персептрон с булевым выходом:

Входы: x1…xn

Вывод: o(x1….xn)

Веса: wi=> вклад входа xi в выход персептрона;

w0=> смещение или порог

Если ∑wx > 0, выход равен +1, иначе -1. Нейрон срабатывает только тогда, когда взвешенный вход достигает определенного порогового значения.

Выход +1 указывает, что нейрон сработал. Выход -1 указывает, что нейрон не сработал.

«sgn» обозначает знаковую функцию с выходом +1 или -1.

Ошибка в персептроне

В правиле обучения персептрона прогнозируемый выход сравнивается с известным выходом. Если он не совпадает, ошибка распространяется назад, чтобы позволить корректировке веса.

Давайте обсудим функцию принятия решения персептроном в следующем разделе.

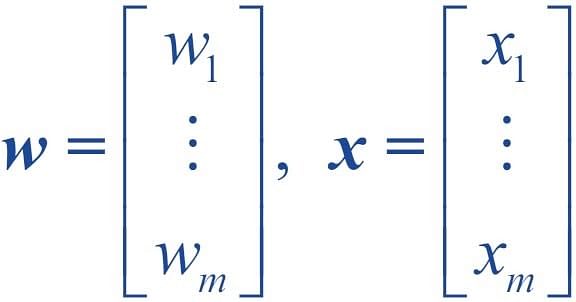

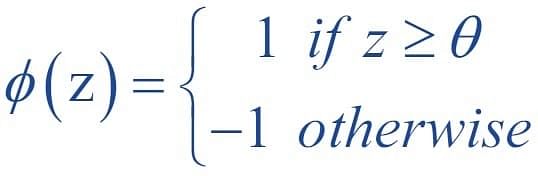

Персептрон: функция принятия решения

Функция решения φ(z) персептрона определяется как линейная комбинация векторов x и w.

Значение z в решающей функции определяется по формуле:

Функция решения равна +1, если z больше порогового значения θ, и -1 в противном случае.

Это алгоритм персептрона.

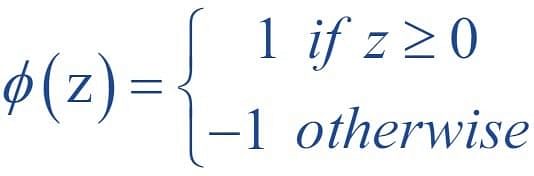

Единица смещения

Для простоты порог θ можно перенести влево и представить как w0x0, где w0= -θ и x0= 1.

Значение w0 называется единицей смещения.

Тогда функция принятия решения будет иметь вид:

Выход:

На рисунке показано, как функция принятия решения сжимает wTx до +1 или -1 и как ее можно использовать для различения двух линейно разделимых классов.

Персептрон вкратце

Персептрон имеет следующие характеристики:

- Персептрон — это алгоритм контролируемого обучения однослойных бинарных линейных классификаторов.

- Оптимальные весовые коэффициенты изучаются автоматически.

- Веса умножаются на входные характеристики, и принимается решение, активируется нейрон или нет.

- Функция активации применяет правило шага для проверки того, больше ли нуля выход весовой функции.

- Проводится линейная граница принятия решений, позволяющая различать два линейно разделимых класса +1 и -1.

- Если сумма входных сигналов превышает определенный порог, он выдает сигнал; в противном случае выходной сигнал отсутствует.

Типы функций активации включают знаковые, ступенчатые и сигмоидальные функции.

Реализация логических вентилей с помощью персептрона

Персептрон – Классификатор Гиперплоскость

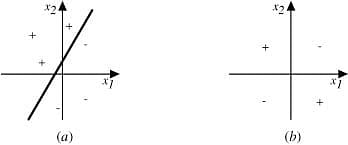

Правило обучения персептрона сходится, если два класса могут быть разделены линейной гиперплоскостью. Однако, если классы не могут быть идеально разделены линейным классификатором, это может привести к ошибкам.

Как обсуждалось в предыдущей теме, граница классификатора для двоичного выхода в персептроне представлена уравнением, приведенным ниже:

![]()

На диаграмме выше показана поверхность принятия решений, представленная двухвходовым персептроном.

Наблюдение:

- На рис.(a) выше примеры можно четко разделить на положительные и отрицательные значения; следовательно, они линейно разделимы. Это может включать логические вентили, такие как AND, OR, NOR, NAND.

- На рис. (b) показаны примеры, которые не являются линейно разделимыми (как в вентиле XOR).

- Диаграмма (а) представляет собой набор обучающих примеров и поверхность принятия решений персептрона, который правильно их классифицирует.

- Диаграмма (б) представляет собой набор обучающих примеров, которые не являются линейно разделимыми, то есть их нельзя правильно классифицировать никакой прямой линией.

- X1 и X2 — входы персептрона.

В следующем разделе поговорим о логических вентилях.

Что такое логический вентиль?

Логические вентили являются строительными блоками цифровой системы, особенно нейронных сетей. Короче говоря, это электронные схемы, которые помогают в сложении, выборе, отрицании и комбинировании формировать сложные схемы. Используя логические вентили, нейронные сети могут обучаться самостоятельно, без необходимости вручную кодировать логику. Большинство логических вентилей имеют два входа и один выход.

Каждый терминал имеет одно из двух бинарных состояний, низкое (0) или высокое (1), представленных различными уровнями напряжения. Логическое состояние терминала изменяется в зависимости от того, как схема обрабатывает данные.

На основании этой логики логические вентили можно разделить на семь типов:

- И

- НЕ-И

- ИЛИ

- НИ

- НЕТ

- XOR

- X-NOR-функция

Реализация базовых логических вентилей с помощью персептрона

Ниже рассматриваются логические вентили, которые можно реализовать с помощью Perceptron.

1. И

Если оба входа имеют значение ИСТИНА (+1), выход Персептрона положительный, что равнозначно ИСТИНА.

Это желаемое поведение вентиля И.

x1= 1 (ИСТИНА), x2= 1 (ИСТИНА)

w0 = -.8, w1 = 0.5, w2 = 0.5

=> o(x1, x2) => -.8 + 0.5*1 + 0.5*1 = 0.2 > 0

2. ИЛИ

Если хотя бы один из двух входов имеет значение ИСТИНА (+1), выход Персептрона положительный, что равнозначно значению ИСТИНА.

Это желаемое поведение вентиля ИЛИ.

x1 = 1 (ИСТИНА), x2 = 0 (ЛОЖЬ)

w0 = -.3, w1 = 0.5, w2 = 0.5

=> o(x1, x2) => -.3 + 0.5*1 + 0.5*0 = 0.2 > 0

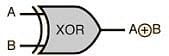

3. Исключающее ИЛИ

Элемент XOR, также называемый элементом «исключающее ИЛИ», имеет два входа и один выход.

Вентиль возвращает значение ИСТИНА в качестве выходного сигнала только в том случае, если одно из входных состояний является истинным.

Таблица истинности XOR

Вход | Выход | |

А | Б | |

0 | 0 | 0 |

0 | 1 | 1 |

1 | 0 | 1 |

1 | 1 | 0 |

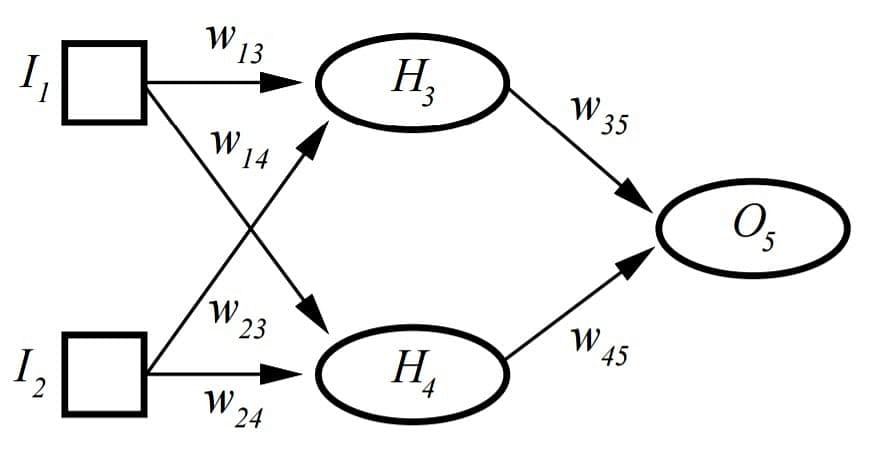

XOR-ворота с нейронными сетями

В отличие от вентилей И и ИЛИ, для вентиля XOR требуется промежуточный скрытый слой для предварительного преобразования с целью достижения логики вентиля XOR.

XOR-ворота назначают веса так, чтобы выполнялись условия XOR. Это не может быть реализовано с помощью однослойного персептрона и требует многослойного персептрона или MLP.

H представляет собой скрытый слой, который позволяет реализовать XOR.

I1, I2, H3, H4, O5 — 0 (ЛОЖЬ) или 1 (ИСТИНА)

t3= порог для H3; t4= порог для H4; t5= порог для O5

H3= сигмовидная (I1*w13+ I2*w23–t3); H4= сигмовидная (I1*w14+ I2*w24–t4)

O5= сигмовидная (H3*w35+ H4*w45–t5);

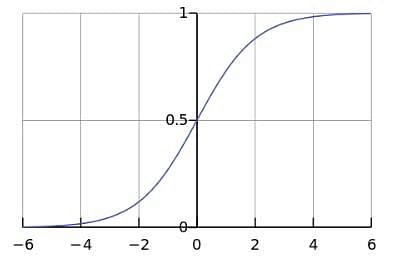

А теперь давайте узнаем больше о функции активации сигмоиды!

Функция активации сигмовидной кишки

На схеме ниже показан персептрон с сигмоидной функцией активации. Сигмоидная функция является одной из самых популярных функций активации.

Сигмоидальная функция — это математическая функция с сигмоидальной кривой («S»-кривая). Это частный случай логистической функции, которая определяется функцией, приведенной ниже:

Здесь значение z равно:

![]()

Сигмовидная кривая

Здесь показана кривая сигмоидальной функции, называемая «S-кривой».

Это называется логистической сигмоидой и приводит к вероятности значения от 0 до 1.

Это полезно в качестве функции активации, когда интерес представляет собой отображение вероятностей, а не точные значения входного параметра t.

Сигмоидальный выход близок к нулю для сильно отрицательного входа. Это может быть проблемой при обучении нейронной сети и может привести к медленному обучению и попаданию модели в локальные минимумы во время обучения. Следовательно, гиперболический тангенс более предпочтителен в качестве функции активации в скрытых слоях нейронной сети.

Сигмоидальная логика для выборочных данных

Выход

Выходной сигнал персептрона равен 0,888, что указывает на вероятность того, что выходной сигнал y равен 1.

Если сигмоид выводит значение больше 0,5, вывод помечается как ИСТИНА. Поскольку вывод здесь равен 0,888, окончательный вывод помечается как ИСТИНА.

В следующем разделе сосредоточимся на функциях выпрямителя и softplus.

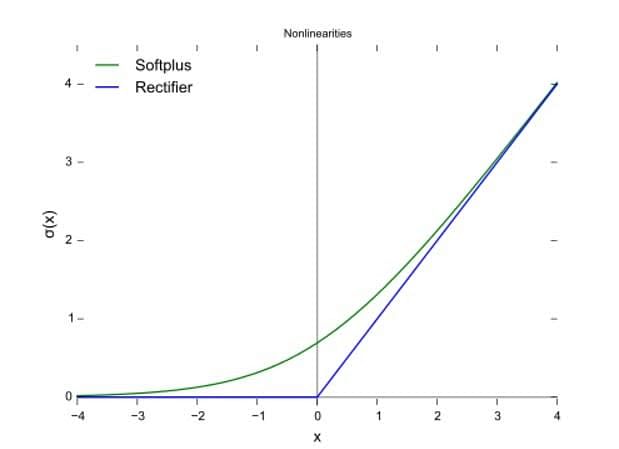

Функции выпрямителя и Softplus

Помимо функций активации Sigmoid и Sign, рассмотренных ранее, другими распространенными функциями активации являются ReLU и Softplus. Они устраняют отрицательные единицы, поскольку выход функции max выведет 0 для всех единиц 0 или меньше.

Выпрямитель или ReLU (Rectified Linear Unit) — это часто используемая функция активации. Эта функция позволяет исключить отрицательные единицы в ANN. Это самая популярная функция активации, используемая в глубоких нейронных сетях.

- Плавным приближением к выпрямителю является функция Softplus.

- Производной Softplus является логистическая или сигмоидальная функция.

В следующем разделе рассмотрим преимущества функции ReLu.

Преимущества функций ReLu

Преимущества функции ReLu следующие:

- Позволяет быстрее и эффективнее обучать глубокие нейронные архитектуры на больших и сложных наборах данных.

- Редкая активация только около 50% единиц в нейронной сети (поскольку отрицательные единицы исключаются)

- Более правдоподобно или односторонне, по сравнению с антисимметрией tanh

- Эффективное распространение градиента, что означает отсутствие проблем с исчезновением или взрывным ростом градиента

- Эффективные вычисления с использованием только сравнения, сложения или умножения

- Хорошо масштабируется

Ограничения функций ReLu

- Недифференцируемость в нуле. Недифференцируемость в нуле означает, что значения, близкие к нулю, могут давать непоследовательные или трудно поддающиеся обработке результаты.

- Центрирование по ненулевым значениям. Центрирование по ненулевым значениям создает асимметрию вокруг данных (обрабатываются только положительные значения), что приводит к неравномерной обработке данных.

- Неограниченный — выходное значение не имеет ограничений и может привести к вычислительным проблемам при передаче больших значений.

- Проблема умирания ReLU. Когда скорость обучения слишком высока, нейроны ReLU могут стать неактивными и «умереть».

В следующем разделе сосредоточимся на функции Softmax.

Функция Softmax

Другая очень популярная функция активации — это функция Softmax. Softmax выводит вероятность принадлежности результата к определенному набору классов. Это похоже на логику категоризации в конце нейронной сети. Например, ее можно использовать в конце нейронной сети, которая пытается определить, содержит ли изображение движущегося объекта животное, автомобиль или самолет.

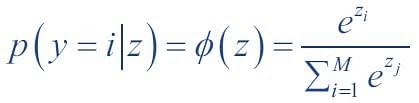

В математике функция Softmax или нормализованная экспоненциальная функция является обобщением логистической функции, которая сжимает K-мерный вектор произвольных действительных значений до K-мерного вектора действительных значений в диапазоне (0, 1), которые в сумме дают 1.

В теории вероятностей выход функции Softmax представляет собой распределение вероятностей по K различным исходам.

В Softmax вероятность принадлежности конкретного образца с чистым входом z к i-му классу можно вычислить с помощью нормировочного члена в знаменателе, то есть суммы всех M линейных функций:

Функция Softmax используется в ИНС и наивных байесовских классификаторах.

Например, если мы возьмем входные данные (1,2,3,4,1,2,3), то Softmax для них будет равен (0,024, 0,064, 0,175, 0,475, 0,024, 0,064, 0,175). Выходные данные имеют большую часть веса, если исходные входные данные равны '4'. Эта функция обычно используется для:

- Выделение наибольших значений

- Подавление значений, которые значительно ниже максимального значения.

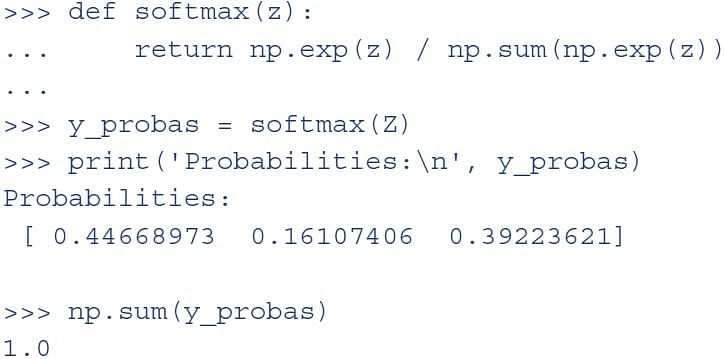

Здесь демонстрируется функция Softmax.

Этот код реализует формулу softmax и выводит вероятность принадлежности к одному из трех классов. Сумма вероятностей по всем классам равна 1.

Давайте поговорим о гиперболических функциях в следующем разделе.

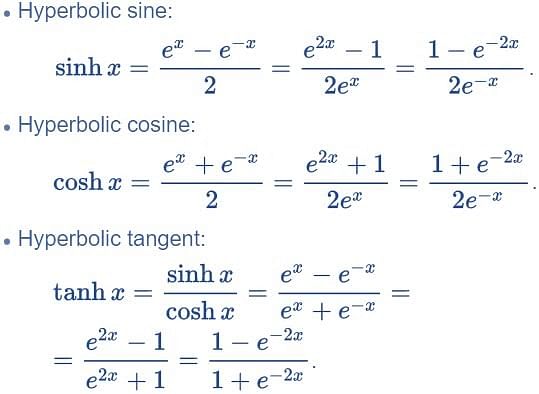

Гиперболические функции

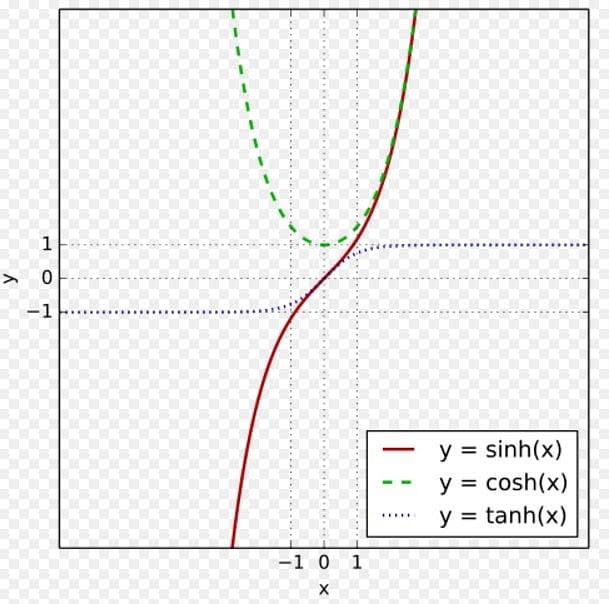

1. Гиперболический тангенс

Гиперболическая или тангенс-функция часто используется в нейронных сетях в качестве функции активации. Она обеспечивает вывод между -1 и +1. Это расширение логистической сигмоиды; разница в том, что вывод здесь простирается между -1 и +1.

Преимущество гиперболического тангенса перед логистической функцией заключается в том, что он имеет более широкий выходной спектр и диапазон находится в открытом интервале (-1, 1), что может улучшить сходимость алгоритма обратного распространения.

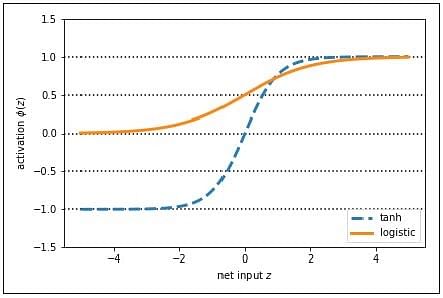

2. Гиперболические функции активации

На графике ниже показана кривая этих функций активации:

Помимо этого, для функции активации могут также использоваться tanh, sinh и cosh.

На основе желаемого результата специалист по анализу данных может решить, какие из этих функций активации необходимо использовать в логике персептрона.

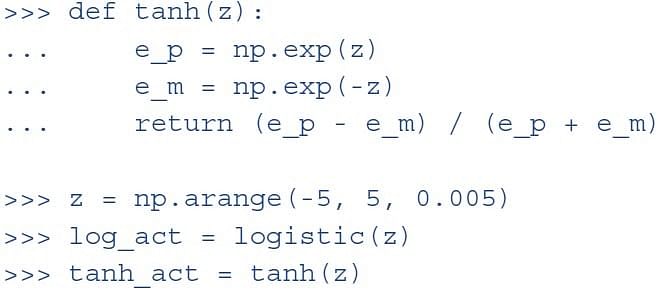

3. Гиперболический тангенс

Этот код реализует формулу tanh. Затем он вызывает обе функции — логистическую и tanh — для значения z. Функция tanh имеет в два раза большее выходное пространство, чем логистическая функция.

Благодаря большему выходному пространству и симметрии относительно нуля функция tanh обеспечивает более равномерную обработку данных, и в функции потерь легче достичь глобальных максимумов.

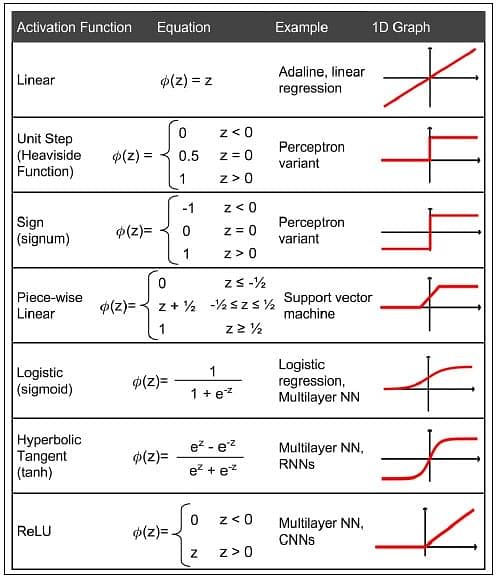

Краткий обзор функций активации

Ниже показаны различные функции активации, которые можно использовать с Perceptron:

Функция активации, которая будет использоваться, является субъективным решением, принимаемым специалистом по данным, на основе постановки проблемы и формы желаемых результатов. Если процесс обучения идет медленно или имеет исчезающие или взрывные градиенты, специалист по данным может попытаться изменить функцию активации, чтобы посмотреть, можно ли решить эти проблемы.

Будущее персептрона

С ростом популярности и использования машинного обучения будущее персептрона кажется значительным и перспективным. Он помогает интерпретировать данные, создавая врожденные шаблоны и применяя их в ближайшее время. Кодирование непрерывно развивается в эту эпоху, и конец технологии персептрона продолжит поддерживать и облегчать аналитическое поведение в машинах, что добавит еще большую эффективность современным компьютерам.

Краткое содержание

Давайте подведем итог тому, что мы узнали в этом уроке:

- Искусственный нейрон — это математическая функция, задуманная как модель биологических нейронов, то есть нейронной сети.

- Персептрон — это нейронная сетевая единица, которая выполняет определенные вычисления для обнаружения признаков или бизнес-аналитики во входных данных. Это функция, которая отображает свой вход «x», который умножается на изученный весовой коэффициент, и генерирует выходное значение «f(x)».

- «Правило обучения персептрона гласит, что алгоритм автоматически выучит оптимальные весовые коэффициенты.

- Однослойные персептроны могут обучаться только линейно разделимым шаблонам.

- Многослойный персептрон или нейронная сеть прямого распространения с двумя или более слоями обладают большей вычислительной мощностью и могут обрабатывать нелинейные закономерности.

- Персептроны могут реализовывать логические вентили типа И, ИЛИ или исключающее ИЛИ.

Заключение

В предыдущем обсуждении мы узнали о моделях персептрона, простейшем типе искусственной нейронной сети, которая переносит входные данные и их веса, сумму всей взвешенной информации и функцию активации. Все модели персептрона непрерывно вносят вклад в AIML. Модели персептрона помогают компьютеру работать более эффективно над сложными задачами с использованием технологий машинного обучения. Это основы искусственных нейронных сетей, и каждый должен знать такие модели для углубленного изучения нейронных сетей.

На этом мы подошли к концу этого руководства по персептрону, который является одной из самых важных концепций ИИ. Это одна из часто задаваемых тем в вопросах интервью по глубокому обучению. Однако, если вы хотите освоить ИИ, запишитесь на курс по ИИ Simplilearn и станьте инженером по ИИ, и откройте для себя возможности трудоустройства, как никогда раньше!

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)